科学家最近发现AI模型6小时就能生成四万种毒性化学分子,甚至有的毒性比VX神经毒剂还强!

新冠疫情肆虐全球两年多的时间里,给人类社会带来了巨大的经济损失,也有人猜测病毒的来源是否为实验室泄漏。

如果说AI模型也能创造出生化武器,那以AI预测的效率来看,人类真能抵御住吗?

去年一个药物发现公司Collaborations Pharmaceuticals的研究人员在《Nature机器智能》上发表了一篇报告,他们发现使用机器学习模型的话,不到六个小时就能发现四万个潜在的致命分子。

研究人员刚发现这个结论的时候简直惊呆了,因为这个过程比想象中要简单很多,十分容易复现。

其中有些新物质甚至和VX神经毒剂类似,吸入5-10分钟即可导致抽搐、麻痹、痉挛,10-15分钟就会死亡。VX毒剂曾被日本邪教利用,造成1人死亡。

如果AI能够大规模生产这类化学武器,又不受管控,那无疑是全人类的灾难,所以研究人员立刻报告了技术滥用的潜在风险。

AI生化武器

为了防止化学武器和生物武器对人类自身造成打击,多个国家联合签订具有严格核查机制的国际军控条约《禁止化学武器公约》和《禁止生物武器公约》,要求全面禁止发展生产以及储存且彻底销毁一整类大规模杀伤性武器。

瑞士联邦核、生物和化学保护研究所(The Swiss Federal Institute for NBC )的Spiez实验室召开了由瑞士政府设立的convergence系列会议,以确定化学、生物学和可能对《禁止化学武器公约》和《禁止生物武器公约》产生影响的技术发展。

这些会议每两年举行一次,汇集了一批国际科学和裁军专家,探讨化学和生物领域的技术现状及其发展轨迹,思考潜在的安全影响,并考虑如何最有效地在国际上管理这些影响。

论文作者Urbina所在药物公司也受到邀请,也就有了这篇报告。

不过Urbina的日常工作并非是制造毒药,而是使用机器学习模型对新生产药物的毒性进行预测。无论公司试图开发什么样的药物,都需要确保它们不会有毒性。

比如你有了一种超强的药物,通过实验可以证明可以很好地降低血压,但它的副作用却是击穿心脏通道,那么这种药是不可能上市的,因为实在是太危险了。

在参加会议的时候,Urbina才意识到,我们建立机器学习模型的目的是获得越来越好的预测毒性的能力来避免毒性,但反过来,如果我们的目的变为「制造毒性」,那是不是性能也会很好?

Urbina介绍模型的具体实现时,他表示需要隐瞒一些具体的实现细节,以防止被有心之人利用。

这个实验的大体工作流程就是,通过利用研发历史中积累的分子数据集,因为这些分子已经被测试过是否包含毒性了,所以可以作为预测标签。

一个特别要关注的例子是VX神经毒剂,一种乙酰胆碱酯酶的抑制剂。每当你做任何与肌肉有关的事情时,你的神经元都需要使用乙酰胆碱酯酶作为信号,然后才能移动肌肉。VX的致命方式是它实际上阻止了你的横膈膜,你的肺部肌肉就不能移动了,从而导致肺部变得麻痹,无法呼吸。

很显然会有大量围绕VX神经毒剂的研究,他们已经用不同类型的分子做了实验,看它们是否同样能够抑制乙酰胆碱酯酶。于是,Urbina建立了这些分子结构的大型数据集,以及它们的毒性如何。

然后就可以使用这些数据集来创建一个机器学习模型,该模型基本上可以学习分子结构的哪些部分对毒性很重要,哪些不重要。然后就可以给这个机器学习模型提供新的分子,可能是以前从未测试过的新药物。

它的输出结果就会告诉我们哪些药物被预测为有毒,或被预测为无毒。这种方法使研究人员能够非常非常快速地筛选出大量的分子,并找出那些被预测为有毒的分子。

模型的另一个关键部分是分子的生成模型。可以通过给生成模型输入一大堆不同的结构,它可以学习如何把分子放在一起。然后在某种意义上,就可以要求它生成新的分子。此时生成模型虽然可以在整个化学空间中生成新的分子,但只是一些随机的分子,并没有任何意义。

研究人员需要做的是告诉生成模型想朝着哪个方向生成,通过设计一个评分函数就可以做到这点。如果它生成的分子是我们想要的东西,就给它一个高分。假设我们要生成毒剂,那就给有毒分子打高分。

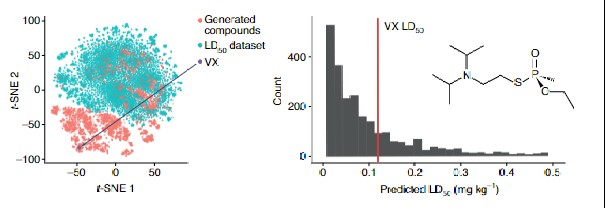

实验结果可以看到模型开始生成的这些分子,其中很多看起来像VX,也很像其他化学毒剂。

因为生成模型还是比较新的技术,Urbina也不确定能得到什么样的结果,目前还没有广泛使用生成模型。

但一个值得注意的问题是,很多生成化合物的毒性预测结果比VX的毒性更大。令人震惊的是,VX基本上是已知的最有效的化合物之一,也就意味着只需要非常、非常、非常少的量就能致死。

虽然这些预测结果还没有在现实中逐一进行验证,研究人员也表示他们也不想自己去验证,但预测模型一般来说都是相当好的。因此,即使有很多假阳性反应,其中应该也会有毒性更强的分子。

其次,看过这些新生成分子的结构后,可以发现一些模型中生成的是真正的化学毒剂。并且这些是在模型从未见过这些化学毒剂的情况下从模型中生成的。

所以毋庸置疑,模型肯定能够生成一些有毒的分子,因为其中一些分子以前就已经被制造出来过。

另一个需要重点关注的内容是,它到底有多容易实现。

研究人员表示,他们开发过程中使用的很多东西都是免费的。你可以从任何地方下载一个毒性数据集,并且如果有一个人知道如何用Python编程,并且有一些机器学习的能力,那么可能在一个周末的工作中就建立类似于这种由有毒数据集驱动的生成模型。

这也是促使研究人员真正考虑把这篇论文发表出来的原因:对于这种类型的滥用来说,它的门槛实在是太低了。

Urbina在论文中表示:我们仍然跨越了一个灰色的道德界限,证明有可能在不需要付出太多精力、时间或计算资源的情况下就设计出潜在的有毒分子。虽然我们可以轻易地删除我们创造的成千上万的分子,但我们不能删除如何重新创造它们的知识。

「既然我们能做,那也许某个地方的敌人已经在考虑这个问题了」,所以Urbina不得不公之于众。

对化学研究的从业者来说,从入行开始就被告知化学用品可能被滥用的风险,但很少有AI从业者了解过机器学习被滥用的风险及相应的指导。

Urbina最后表示,我不想危言耸听,说可能会有人工智能驱动的化学战,因为我不认为现在能做到,我也不认为这件事很快就会成为现实。但随着AI的发展,这确实成为了一种危险可能性事件。